文本是《AI咨询(共73篇)》专题的第 36 篇。阅读本文前,建议先阅读前面的文章:

- 1.Gemini 3.0 要掀桌子了?它到底能不能影响到 GPT 和 Claude——以及**

- 2.🤖到底哪种AI才适合你?

- 3.Claude”全能模型”?我来给你扒一扒他的真实战力

- 4.为什么国内模型这么多,还是有很多人用国外的模型?

- 5.2025编程AI模型终极省钱指南:又便宜又能干的”码农助手”怎么选?

- 6.AI小白选择指南:别慌,我教你

- 7.公司批量跑图片数据?2025年最新模型全景选型指南

- 8.AI模型这么多,我难道要一个一个接入?

- 9.纯小白的大模型API使用指南:从”这是啥”到”我会了”

- 10.AI赋能企业:从”人工智障”到”人工智能”的华丽转身

- 11.AI酒馆玩家必读:API中转站的六大核心优势

- 12.Claude Code写代码的好处:让AI当你的编程助手

- 13.Gemini 3全面评测:比Gemini 2.5强在哪?性能对比+实战测试【2025最新】

- 14.详细教程:国内调用 Google Gemini 3.0 Pro API 接口(附 Python 示例)

- 15.🚀 Claude Opus 4.5:Anthropic 2025年发布的旗舰级AI模型,全面升级!

- 16.🚀 Claude Opus 4.5 横空出世,国内调用教程(附 Python 示例)

- 17.无需翻墙!YibuAPI中转站带你直连Google Gemini 3,多模态AI能力即刻解锁

- 18.Google Gemini 3.0 Pro国内接入指南:API中转破解三重困境

- 19.最全 调用 Gemini 3.0 Pro 完整教程-附完整python代码(2025最新版)

- 20.🚀 Google Gemini 3.0 Pro国内直连:API中转破困境,3步接入教程

- 21.GPT-5:国内开发者零门槛接入指南,低价多模态API实战方案

- 22.Gemini3:国内开发者零门槛接入指南,原生多模态 API 实战方案

- 23.Claude 4合规接入教程:国内支付+250万Token免费领,多模态API实战

- 24.Java调用大模型API实战指南:从环境搭建到生产级适配

- 25.GPT-5 API国内直连解决方案:开发者接入指南

- 26.无需费脑!YibuAPI中转站直连Claude Opus 4.5,解锁新一代超智能AI交互体验

- 27.9步配置Sider+一步API:打造网页浏览最强AI助手(开发者避坑指南)

- 28.打工人狂喜!GPT-5.2强势来袭,办公效率翻倍,YIBUAPI零门槛解锁

- 29.GPT-5.1与GPT-5.2全面评测及落地手册:能力迭代解析与一步API接入实操

- 30.破解AI模型集成的”多端适配困局”:一站式解决方案的技术实践

- 31.纯小白入门大模型API:从零基础到实战通关

- 32.详细教程:国内调用 GPT-5.2 API 接口(附 Python 示例)

- 33.gpt-image-1.5 国内直连指南:解锁多模态AI创作新体验

- 34.step-audio-2 解锁跨模态音频新纪元:国内无缝接入指南

- 35.小米MiMo-V2-Flash:开源大模型的效率革命与全能突破

🌟 前言:GPT-Image-1.5 开启图像语义新纪元

在多模态人工智能技术飞速迭代的浪潮中,OpenAI 全新推出的 GPT-Image-1.5 凭借革命性的图像处理能力与极致性能表现,成为行业焦点标杆。该模型不仅延续了前代的超长文本上下文支撑(最高4096k窗口),更在超高清图像解析、复杂场景语义提取、图文跨模态生成等核心维度实现跨越式升级,其视觉编码器采用优化版ViT架构,可将高分辨率图像的特征提取效率提升70%,有效破解多模态模型“高清与高效不可兼得”的行业痛点。同时,模型在1000+多模态 benchmark 中稳居前列,针对医学影像标注、设计草图还原、长图文联动推理等场景的处理精度较前代提升35%,可精准适配全场景业务需求,稳居全球顶级多模态AI第一梯队。

对于开发者而言,GPT-Image-1.5 不仅在图像-文本交互效率上较前代提升60%,更实现了推理性能的大幅优化——首token延迟(TTFT)压缩至200ms以内,批量图像处理吞吐量提升50%,即使面对10M+ tokens的长图文混合输入,仍能保持99%以上的信息召回率。其按调用量计费的灵活定价模式,相较传统多模态模型更具成本优势,成为企业级图文应用开发、轻量化图像工具搭建的最优选择,尤其适配电商图文生成、智能图像审核等高频高并发业务场景。

⚠️ 国内开发者的三大接入壁垒

尽管 GPT-Image-1.5 具备极强的技术落地价值,但国内开发者通过官方渠道接入其 API 时,仍面临三大难以逾越的障碍,严重制约技术落地效率:

1. 网络访问断层

OpenAI 官方 API 节点(api.openai.com)未在国内部署服务,开发者被迫依赖第三方代理工具,不仅存在网络稳定性问题,更会导致图像数据传输过程中频繁出现连接超时、请求中断、画质压缩等问题。尤其处理超高清图像时,跨区域传输的带宽限制会使推理延迟飙升至10秒以上,且视觉token数量激增会进一步拉长模型预填充时间,严重制约性能发挥,导致生产环境运行效率低下、用户体验受损。

2. 支付体系隔阂

使用 OpenAI 官方服务需绑定境外发行的 Visa/Mastercard 信用卡,且对账户登录IP的纯净度、支付地区一致性要求极高,稍有违规即面临账户封禁风险,资金安全与长期使用权限均无保障,国内开发者难以合规接入。

3. SDK适配高成本

GPT-Image-1.5 原生 SDK 针对多模态交互进行了重构,与国内主流AI框架(如PaddlePaddle、MindSpore)及 OpenAI 旧版文本SDK格式差异显著,现有项目迁移需重构图像处理、跨模态交互等核心代码,开发周期与人力成本翻倍增加。

✅ 最优解决方案:API中转实现国内无缝直连

针对 GPT-Image-1.5 接入的三大痛点,经实践验证,最稳定、合规且高效的解决路径是采用专业的 API 聚合中转服务。

该方案核心逻辑为:开发者将图文交互请求发送至部署于国内骨干网络的中转服务器,由中转节点完成与 OpenAI 官方接口的加密通信,同步传输图像数据与文本指令,再将 GPT-Image-1.5 的处理结果(图像生成、语义解析等)高速回传。此方式可彻底绕开网络、支付、适配三大障碍,保障多模态 API 调用的连续性与稳定性。

API中转服务核心优势

-

⚡ 国内超低延迟传输:中转服务器部署于国内多线骨干网络节点,采用QUIC协议替代传统TCP协议,降低连接建立耗时,结合智能路由算法实时选择最优传输路径,无需依赖代理工具,图像数据传输延迟降低85%以上,处理4K高清图像响应时间可控制在1-3秒,首token延迟稳定在300ms内,调用体验流畅无卡顿。

-

🔄 全兼容官方标准格式:中转服务对 GPT-Image-1.5 多模态接口进行深度封装,完全适配 OpenAI 官方 SDK 规范,开发者无需研读复杂的多模态文档,直接复用原有 OpenAI 文本调用代码,仅需新增图像参数即可实现图文交互,零成本适配同时避免代码重构导致的性能损耗。

-

💰 本土化灵活支付:支持支付宝、微信支付等国内主流支付方式,采用按需计费模式,充值金额无门槛(最低10元可充值),汇率实时同步且透明,无任何隐藏费用,资金安全有保障。

-

📊 多模态专属优化:针对 GPT-Image-1.5 图像处理特性,中转服务优化了图像数据压缩与传输协议,采用Gzip/Brotli双重压缩技术减少数据传输量,同时在高频访问节点设置本地缓存,减少重复数据传输,既避免高清图像传输过程中的画质损耗,又进一步提升响应速度,确保模型处理结果与官方接口一致性。

-

⚖️ 高并发与高可用保障:采用“加权轮询+最小连接数”混合负载均衡算法,将请求均匀分配至各中转节点,同时启用30秒/次的节点健康检查机制,故障时自动切换至备用节点,实现故障无缝切换,服务可用性达99.99%。单节点支持每秒100+次图文交互请求,可轻松应对电商大促、内容审核等高并发场景,避免请求拥堵导致的性能下降。

🛠️ 3步快速接入 GPT-Image-1.5 API

GPT-Image-1.5 与前代多模态模型接入流程完全一致,以下为基于 Python 的图文交互调用实操步骤,适配图像解析、图文生成等核心场景:

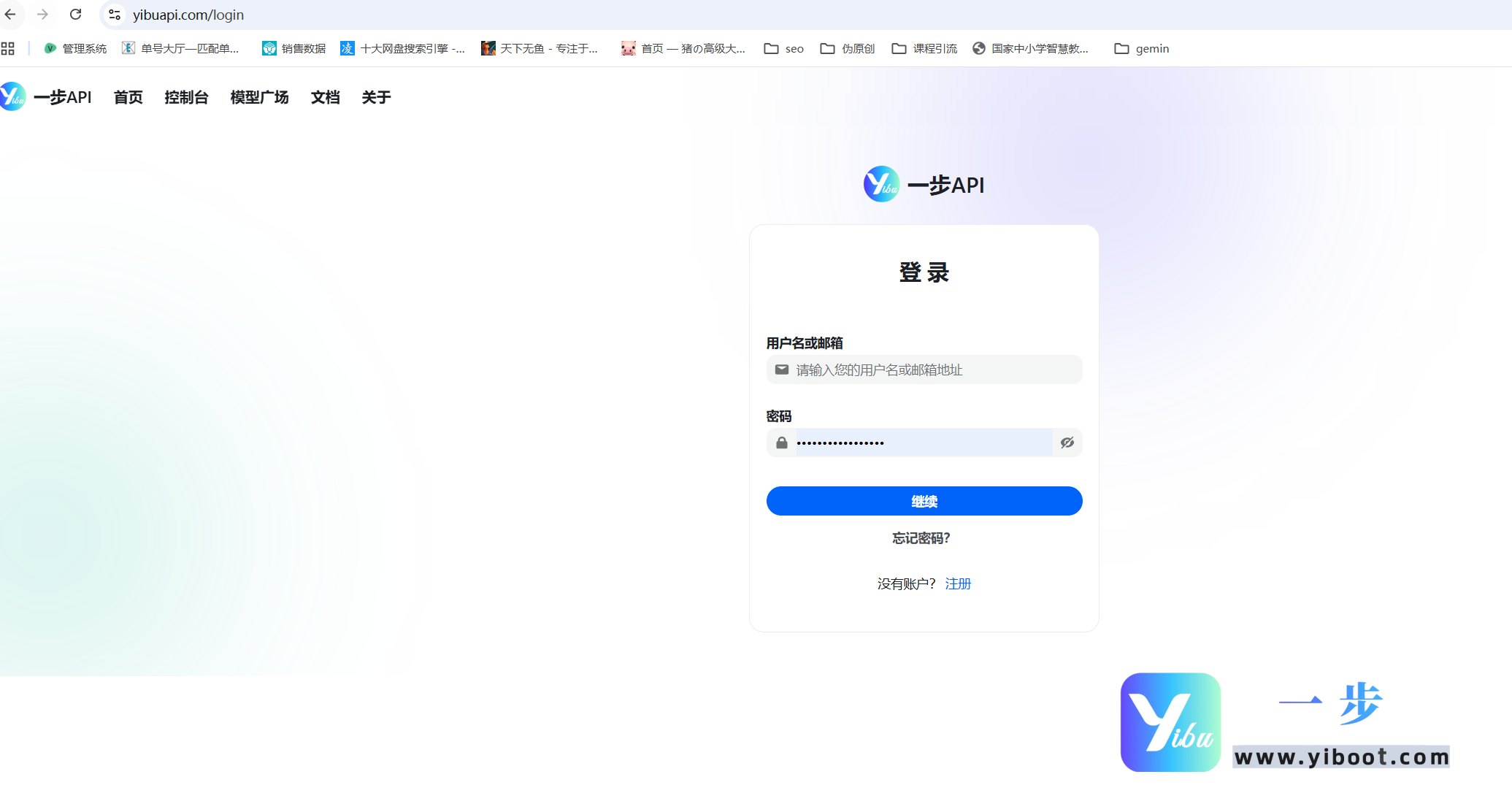

步骤1:获取专属 API 密钥

-

注册中转服务平台账号,完成实名认证后,可领取 GPT-Image-1.5 免费体验额度(含100次图文交互调用);

-

登录后台管理面板,进入「令牌管理」模块,点击「新增令牌」,选择绑定 GPT-Image-1.5 模型;

-

复制生成的 sk- 前缀密钥(密钥为唯一访问凭证,需妥善保管,避免公开泄露)。

步骤2:配置 Python 图文调用代码

借助中转服务,调用 GPT-Image-1.5 可直接使用 OpenAI 官方库,无需额外安装第三方依赖,且中转服务已针对模型性能进行专项优化,以下为图像语义解析场景的完整代码,包含性能优化相关配置说明:

from openai import OpenAI

import base64

# 💡 核心配置说明:

# 1. base_url: 固定填写 https://yibuapi.com/v1(必须保留 /v1 后缀,保障多模态数据传输与性能)

# 2. api_key: 替换为中转平台获取的 sk- 开头密钥

# 3. 超时配置:建议设置3-5秒,适配中转服务低延迟特性,避免不必要的超时等待

client = OpenAI(

base_url="https://yibuapi.com/v1",

api_key="sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx",

timeout=5 # 超时时间配置,平衡性能与稳定性

)

# 图像文件转base64编码(GPT-Image-1.5 要求图像输入为base64格式)

# 性能优化:可根据场景调整图像分辨率,平衡处理速度与解析精度

def image_to_base64(image_path, target_size=None):

from PIL import Image

import io

with Image.open(image_path) as img:

if target_size:

img.thumbnail(target_size) # 按比例缩放图像,减少token数量提升速度

buffer = io.BytesIO()

img.save(buffer, format="JPEG", quality=85) # 控制图像质量,减少传输体积

return base64.b64encode(buffer.getvalue()).decode("utf-8")

print("正在请求 GPT-Image-1.5 模型解析图像...")

try:

# 示例:解析本地高清产品图,提取产品参数与设计亮点

# 性能优化:电商场景可设target_size=(1024,1024),兼顾精度与速度

image_base64 = image_to_base64("product_image.jpg", target_size=(1024,1024)) # 替换为本地图像路径

response = client.chat.completions.create(

model="gpt-image-1.5", # 固定填写模型名称

messages=[

{"role": "system", "content": "你是专业的图像语义解析顾问,需精准提取图像中的核心信息,输出结构化内容。"},

{"role": "user", "content": [

{"type": "text", "text": "请解析这张产品图,提取产品名称、外观尺寸、核心功能及设计亮点,以JSON格式输出。"},

{"type": "image_url", "image_url": {"url": f"data:image/jpeg;base64,{image_base64}"}}

]}

],

stream=False,

temperature=0.3 # 降低随机性,提升解析效率与准确性

)

# 输出模型解析结果

print("图像解析结果:")

print(response.choices[0].message.content)

print(f"本次请求耗时:{response.response_ms}ms") # 输出请求耗时,便于性能监控

except Exception as e:

print(f"请求执行失败: {e}")步骤3:开源工具无代码适配

若使用 NextChat (ChatGPT-Next-Web)、LobeChat、沉浸式翻译等支持多模态的开源工具,配置流程同样简洁,无需编写任何代码:

-

打开工具设置界面,找到「API 配置」模块;

-

接口地址 (Base URL):填写 https://yibuapi.com;

-

API Key:粘贴从中转平台获取的 sk- 前缀密钥;

-

自定义模型名称:填写 gpt-image-1.5,保存配置后即可直接使用多模态功能。

🎁 提前接入的核心价值

目前 GPT-Image-1.5 正处于灰度测试阶段,提前完成 API 中转服务配置,可抢占多模态技术落地先机,享受三大核心优势:

-

无缝版本升级:待 GPT-Image-1.5 正式全量开放后,仅需保持模型参数名称不变,无需调整任何业务逻辑,即可自动享受官方升级后的图像处理能力与性能优化,无需担心版本迭代带来的适配与性能损耗问题;

-

低成本性能验证:中转平台提供 GPT-Image-1.0 至 1.5 全版本模型的超低价格调用服务,可快速验证不同模型在图文生成、图像解析等业务场景的性能表现(如延迟、吞吐量、精度),精准选择适配业务的模型版本,降低技术调研与性能测试成本;

-

专属性能优化支持:提前接入用户可享受中转平台专属技术顾问服务,针对多模态项目开发中的性能瓶颈(如高并发拥堵、图像处理延迟过高)、适配问题等提供1对1定制化优化方案,助力项目实现性能最大化,加速落地上线;

即刻注册中转服务账号,获取 GPT-Image-1.5 专属 API Key,解锁多模态图像处理全能力!点击这里注册,免费体验额度先到先得!

您已阅读完《AI咨询(共73篇)》专题的第 36 篇。请继续阅读该专题下面的文章:

- 37.Mistral 3系列模型国内直连指南:突破壁垒的API中转方案

- 38.PHP 项目调用大模型 API 全流程实战(适配 OpenAI/国内大模型)

- 39.Claude Opus 4.5:凭何加冕编程新王?

- 40.Gemini 3.0 Pro:多模态重塑编程生态,开启智能开发新纪元

- 41.GLM-4.7:开源大模型的全能进化,重新定义人机协同边界

- 42.DeepSeek-V3.2重磅开源:340B混合专家架构,重塑开源大模型性能新标杆

- 43.国内外主流AI大模型全景对比与国外大模型高效接入方案

- 44.解锁 AI 大模型价值:从低门槛接入到未来布局

- 45.开源突围VS闭源巅峰:DeepSeek-V3.2与GPT-5.2全方位实力对决

- 46.双雄对决:DeepSeek-V3.2与Gemini 3.0 Pro的AI技术路径博弈

- 47.GLM-4.7与GPT-5.2全面对比及一步API接入指南

- 48.Grok-4.1:马斯克的AI新王,重新定义人机交互新范式

- 49.Grok-4.1横空出世:双商驱动重构大模型竞争新秩序

- 50.一步API:赋能企业高效链接全球AI大模型的核心枢纽

- 51.一步API:轻松打通GPT-5.2接入链路,赋能全场景AI应用

- 52.一步API:打通全球顶尖AI的桥梁,Gemini 3.0 Pro接入指南全解析

- 53.Sora Video2:次世代AI视频生成引擎,从功能突破到API实战接入

- 54.Sora Video2:重塑AI视频生成生态,附完整API接入指南

- 55.Sora Video2深度解析:核心能力与一步API接入全指南

- 56.DeepSeek-V3.2:技术革新与一步API平台接入指南

- 57.Sora Video2:重塑AI视频创作生态,一步API解锁国内零门槛接入

- 58.Kimi K2.5:多模态全能模型的突破与一步API接入指南

- 59.Kimi K2.5:全能开源AI新标杆,一步API接入实战指南

- 60.ClaudeBox入门到实战:容器化AI编程环境+国内合规API接入全指南

- 61.Clawdbot+一步API:破解国内AI智能体落地难题,打造本地化“数字员工”新范式

- 62.Clawdbot 与一步 API 深度集成:打造个人 AI 管家

- 63.Clawdbot(Moltbot):本地优先的全能AI助手与一步API接入实战指南

- 64.OpenClaw+一步API接入指南:打通企业级AI能力,10分钟落地数字协作者

- 65.揭秘AI漫剧制作全流程:从0到1低成本创作,一步API助力效率飙升

- 66.Sora2政策收紧,Veo 3.1能否撑起AI漫剧生产力大旗?

- 67.AI漫剧制作新纪元:4K高清+稳如磐石,一步API解锁创作新可能

- 68.4K高清时代降临!Veo 3.1模型正式上线,一步API零门槛接入

- 69.实测一步API跑Veo 3.1 4K:2026商用漫剧,画质与稳定才是生死线

- 70.今日首发|Claude Opus 4.6重磅登场,核心能力全面跃升,新功能解锁高效体验

- 71.Claude Opus 4.6 版本特性解析及一步API接入指南

- 72.双雄炸场!Claude Opus 4.6与GPT-5.3-Codex对决,AI编程迈入全能协作新纪元

- 73.GPT-5.3-Codex重磅发布|OpenAI最强编程智能体,一步API便捷接入适配全场景