核心要点

- 一体化平台赋能: Dify 是一个开源的大语言模型(LLM)应用开发与运营平台,巧妙融合了 LLMOps 和后端即服务(BaaS)理念,极大简化了生成式 AI 应用的构建与管理。

- 模块化架构设计: 其分层架构包含 API 服务、Worker 异步处理和直观的 Web 前端,确保了平台的高效、可扩展与易用性,为开发者提供了坚实的技术基石。

- 多类型应用支持: Dify 支持开发聊天助手、Agent 智能体和自动化工作流等多种 AI 原生应用,覆盖了从简单对话到复杂任务编排的广泛需求。

- 核心功能卓越: 平台内置强大的 RAG 引擎、灵活的 Agent 框架(支持 Function Calling 和 ReAct)、专业 Prompt IDE 及全面 LLMOps 能力,显著提升了 AI 应用的开发效率与运行表现。

- 市场定位精准: Dify 定位为“生成式 AI 应用创新引擎”,旨在通过低代码/无代码体验、模型中立和私有化部署支持,赋能从非技术人员到资深开发者,加速 AI 创新落地。

- 灵活的部署选择: 提供便捷的 Dify Cloud 云服务和强大的 Docker Compose 本地部署方案,满足不同用户对灵活性、数据安全和资源控制的需求。

概述

想象一下,你有一个绝妙的 AI 应用创意,但面对复杂的大语言模型(LLM)开发、部署和运维流程,望而却步了吗?别担心!今天,我们要深入探索一个真正的“梦想建造者”——Dify。它不仅仅是一个平台,更是一个革命性的工具箱,旨在将前沿的 AI 技术,尤其是大型语言模型的能力,以最直观、最用户友好的方式带到你的指尖。

Dify 的诞生,正是为了解决 AI 应用开发中的痛点:高门槛、高成本、高复杂度。它巧妙地融合了 LLMOps(大语言模型运维)和 Backend as a Service (BaaS)(后端即服务)的精髓,让开发者和非技术人员都能像搭积木一样,快速构建、部署并持续优化生产级的生成式 AI 应用。无论是智能客服、知识库问答,还是更具自主性的 AI 智能体,Dify 都为你铺平了道路,让你能够专注于创意本身,而非繁琐的技术细节。准备好了吗?让我们一起揭开 Dify 的神秘面纱!

详细分析

Dify 的核心定义与理念:AI 时代的“乐高”积木

Dify 的核心,在于它对大语言模型(LLM)应用的开发与运营流程进行了彻底的解构与重塑。它是一个开源平台,致力于让 AI 应用的创建变得前所未有的简单。

-

LLMOps (Large Language Model Operations) - AI 模型的“管家”: 想象一下,一个大语言模型从创意到最终服务用户的整个生命周期,Dify 就像一位尽职尽责的“管家”。它管理着模型选择、提示词(Prompt)编排、数据处理、应用部署、性能监控,甚至还有持续优化。它确保你的 AI 应用不仅能跑起来,还能跑得又快又稳,并且能随着时间不断进化。这就像一个精密的生产线,让 AI 应用的开发不再是手工作坊,而是高效、可扩展的现代化工厂。

-

Backend as a Service (BaaS) - 隐藏在幕后的“超能力”: Dify 把大语言模型的复杂性“藏”了起来。就像你使用一个云服务,无需关心底层服务器的维护、网络的配置,Dify 的 BaaS 让你通过简单的 API 调用,就能瞬间获得强大的 LLM 功能。你不再需要从零开始搭建模型基础设施,而是可以像调用乐高积木一样,将 AI 能力无缝集成到你的应用中。这意味着,你可以把精力完全放在构建用户体验和业务逻辑上,让 Dify 成为你 AI 应用的“幕后英雄”。

-

Agentic AI (智能体 AI) - 拥有“思考力”的AI: 这不仅仅是简单的问答机器人,Agentic AI 赋予了 AI 系统自主决策、规划和执行复杂任务的能力。Dify 提供了构建这些“智能大脑”的强大工具,让你的 AI 不仅能理解你说什么,还能主动思考、调用外部工具(比如搜索、API),甚至根据目标进行多步骤的行动。这就像给你的 AI 装上了“大脑”和“手脚”,让它能独立完成更多工作。

Dify 致力于解决的核心问题直击痛点:

- 降低开发门槛: 让不懂编程的产品经理、市场人员也能轻松上手。

- 简化集成与管理: 统一管理各种 LLM,告别碎片化。

- 提升开发效率: 提供开箱即用的功能,加速从想法到产品的过程。

- 支持持续优化: 通过数据分析和标注,让你的 AI 越用越聪明。

Dify 的技术架构:精妙的“齿轮与枢纽”

Dify 的架构就像一台精密运作的机器,每个组件都各司其职,协同工作,共同支撑起整个平台的强大功能。

-

API 服务模块 (

/api) - 核心大脑: 这是 Dify 的“指挥中心”,基于 Python Flask 构建。所有来自前端、SDK 或外部应用的请求,都会通过这里进行路由、验证,并分配给相应的“工人”。它就像一个高效的接待员,确保每项任务都能准确无误地被接收和处理。 -

Worker (工作器) - 任务执行者: 想象这些 Worker 是 Dify 的“实干家”,专门负责处理那些耗时、复杂的“重活累活”,比如真正地调用大语言模型进行推理、执行复杂的提示词编排、进行工具调用(Tool Calling),以及处理检索增强生成(RAG)的流程。由于这些任务是异步进行的,它们不会阻塞整个系统的运行,就像是工厂里的专业流水线工人,确保高效率。

-

Web 前端模块 (

/web) - 用户的“画板”: 这是你与 Dify 互动的“画板”,基于 Next.js 搭建。它提供了直观的可视化界面,让你能够拖拽、点击,轻松完成应用创建、管理、提示词设计、知识库配置、数据查看和应用发布等一切操作。它将复杂的后端操作转化为简单的视觉呈现,让 AI 开发变得像玩游戏一样有趣。

除此之外,Dify 还有:

- 数据库 (Database): 存储所有关键信息,就像一个巨大的“档案室”。

- 缓存 (Cache): 存储常用数据,提升系统响应速度,就像一个“快速取用区”。

- SDK 模块 (

/sdks): 提供多语言客户端库,方便你的应用轻松集成 Dify 的能力,就像提供了各种“通用连接器”。 - Docker 部署模块 (

/docker): 提供了容器化部署的“蓝图”,让 Dify 的部署变得异常简单,就像一键安装软件。

Dify 支持的应用类型:AI 应用的“家族谱”

Dify 不仅仅是“一个”工具,它能帮助你构建一个完整的 AI 应用“家族”,每个成员都有其独特的能力和适用场景。

| 应用类型 | 定义 | 特点 | 核心区别点 |

|---|---|---|---|

| 聊天助手 | 旨在模拟人类对话,回答问题、提供信息或执行简单任务的对话式 AI 应用。 | 交互性强,即时响应,具备多轮对话和上下文记忆。适用于问答、客服等场景。 | 侧重于对话交互,主要提供信息或执行简单指令,通常不涉及复杂的自主决策或外部工具调用。 |

| Agent | 一种更高级的 AI 应用,具备自主规划、推理和执行复杂任务的能力,能够利用外部工具(如搜索、API)完成多步骤操作,并根据用户目标进行决策和行动。 | 具备自主决策、工具调用、任务分解和规划能力。Dify 支持配置工具和使用 Function Calling 或 ReAct 等推理框架。适用于数据分析、报告撰写、旅行规划等需要自主完成复杂任务的场景。 | 在聊天助手基础上,增加了自主规划、推理和工具使用的能力,能够完成更复杂的、多步骤的任务。核心在于其自主性,即 AI 自己决定如何利用工具和信息来达成目标。 |

| 工作流 | 将多个 AI 能力和/或外部工具按照预设顺序或条件进行编排的应用。将一系列独立的步骤(LLM 调用、工具使用、数据处理等)连接起来,形成一个端到端的自动化流程。 | 强调流程自动化、任务串联和高可定制性。Dify 提供可视化工作流编排器,允许用户通过拖拽和连接节点设计复杂流程。可以是单轮生成任务,也可以是多步骤的批处理任务。Dify 的 Chatflow 增加了聊天和记忆功能。 | 更侧重于自动化和流程编排,将功能模块按照预定义的逻辑顺序串联执行。与 Agent 区别在于,工作流的执行路径通常是预设和确定的,而 Agent 则具有更高的自主性,可动态决定下一步行动。 |

Dify 的应用场景:AI 能力的“星辰大海”

Dify 不仅是一个开发工具,它更是连接 AI 技术与实际业务场景的桥梁。其应用范围之广,令人惊叹!

- 智能客服对话系统: 想象一下,一个全年无休、知识渊博的客服,能够即时回答用户问题,甚至识别复杂查询并无缝转接人工服务。Dify 结合 RAG(检索增强生成)技术,让你的 AI 客服拥有“海量知识库”,例如在金融领域,它能实时分析交易数据,预警风险,守护你的财产安全。

- 企业知识库问答应用: 你的公司是否有堆积如山的内部文档?Dify 可以把这些文档变成活生生的“知识大脑”,用户只需提问,AI 就能给出带引用的精准回答。它支持 TXT、Markdown、PDF、HTML、DOC、CSV 等多种文件格式,让你的知识不再沉睡。

- 内容创作自动化: 还在为写博客、做总结而烦恼吗?Dify 支持智能内容生成工作流,帮你瞬间生成 SEO 友好的文章、精准的文本摘要、甚至多语言的翻译。它能成为你的“AI 写作助理”,大幅提升内容生产效率。

- AI 创意快速验证: 有个新想法想试试水?Dify 让你快速将创意转化为最小可行产品(MVP),几分钟就能搭建一个概念验证,迅速获得市场反馈。

- 智能体(Agent)应用: 想让 AI 自动帮你管理日程、撰写邮件、分析数据?Dify 构建的 AI Agent 可以自主规划、推理并执行复杂任务,成为你日常工作的“超级助手”。比如在医疗领域,Agent 可以快速检索临床研究和患者记录,辅助医生做出更精准的决策。

- 企业 LLM 基础设施: 对于大企业而言,Dify 可以成为内部的 AI 网关,统一管理和部署各种 AI 应用,确保数据安全和高效协作,就像企业的“AI 大管家”。

Dify 的核心功能优势:AI 领域的“瑞士军刀”

Dify 之所以强大,是因为它集成了多项领先功能,宛如一把AI领域的“瑞士军刀”。

-

RAG 引擎(检索增强生成)—— 让 LLM “博学多才”:

- 文件格式支持: 不论是普通文本 (TXT, Markdown)、文档 (PDF, DOC)、网页 (HTML) 还是数据表格 (CSV),Dify 都能自动清理并处理,将非结构化数据转化为 LLM 的“可消化知识”。

- 处理流程: 它就像一个“超级图书馆员”,能够从外部来源实时检索信息,显著增强 LLM 的输出。其内置的 RAG 管道提供可视化知识库管理,支持片段预览和召回测试。在检索策略上,它融合了关键词、文本向量、混合搜索、多路径检索和重排序模型,甚至支持 Qdrant, Weaviate, Milvus 等多种向量数据库,确保你的 AI 总能找到最相关的答案。

-

Agent 框架 —— 赋予 AI “思考和行动”能力:

- 内置工具: Dify 就像一个“工具箱”,内置了超过 40 种实用工具(截至 2024 年第二季度),并且可以直接加载 OpenAPI 规范的 API 作为新工具,比如 Google 搜索、DALL-E 等。

- 工作原理: 它为 AI 赋予了“思考”的能力,支持 Function Calling(函数调用)和 ReAct 两种推理模式。对于支持函数调用的模型(如 GPT-3.5/GPT-4),效果更佳;对于不支持的模型,ReAct 框架也能实现类似的自主决策和工具调用效果。你的 AI Agent 不再是简单的问答机器,而是能够自主规划、任务拆解、调用工具并迭代完成任务的“独立思考者”。

-

Prompt IDE(提示词集成开发环境)—— 打造 LLM 的“灵魂”:

- Dify 提供了一个专业的“提示词工作室”,让你能可视化地设计和管理提示词。你可以轻松嵌入自定义变量,甚至让 LLM 帮你自动编排提示词模板,让你的 AI 拥有更“智慧”的表达。

-

LLMOps(大语言模型运维)—— 保障 AI 的“健康运行”:

- 监控与改进: Dify 提供了全面的“仪表盘”,监控应用的统计数据。更棒的是,它支持对过往聊天和生成内容进行“标注”,纠正模型的错误或提供更优的回答,这些标注数据是优化 AI 性能的“黄金矿产”。

- 内容审查: Dify 像一个“安全卫士”,通过集成 OpenAI Moderation API、敏感词字典和自定义接口,确保 AI 生成的内容安全合规,预防潜在风险。

-

“后端即服务”(Backend as a Service)API —— 轻松集成 AI 能力:

- Dify 提供了封装友好的 API 接口,无论是后端还是前端应用,都能通过简单的 Token 鉴权轻松调用 Dify 的 AI 能力。这就像提供了一个“即插即用”的 AI 模块,让你的开发团队能够专注于核心业务,而非底层 AI 集成。

Dify 的市场定位:AI 时代的“铺路者”

Dify 将自己定位为“生成式 AI 应用创新引擎”,这不仅仅是一个口号,更是其产品理念的真实写照。它旨在让 AI 技术的应用变得触手可及,无论你是技术大牛还是业务专家。

-

目标用户: Dify 的“服务范围”非常广。对于产品经理、市场营销人员、业务分析师来说,它是一个能将想法快速变为现实的“魔法工具”;对于开发者而言,它提供了强大的原型设计和部署能力,让他们能更高效地工作。简单来说,只要你渴望构建和部署生成式 AI 应用,Dify 就在那里等你。

-

竞争优势: Dify 在市场中脱颖而出,凭借以下几个“秘密武器”:

- AI 原生设计: 从底层基因就为 AI 应用而生,提供了完整的 AI 工具链。

- 低代码/无代码: 这是它的“杀手锏”,让非技术人员也能参与 AI 创新。

- 一体化平台: 将 RAG、工作流、可观测性、模型管理整合于一处,告别“工具散落一地”的烦恼。

- 灵活模型集成: 像一个“模型博物馆”,全面支持全球主流的开源和闭源大语言模型,让你自由选择、轻松切换。

- 私有部署: 对于金融等对数据安全有极高要求的行业,Dify 提供了私有化部署选项,确保数据始终掌握在企业手中,就像为你的数据建了一座“堡垒”。

-

市场前景: Dify 瞄准的是那些追求高性能、高质量 AI 应用的中高端用户。其强大的技术研发团队,加上与亚马逊云科技等巨头的合作,正在全球范围内加速其市场拓展。Dify 不仅能帮助企业提升效率,更能在激烈的市场竞争中,为你创造独特的 AI 驱动优势。

AI开发平台对比分析矩阵:谁是你的AI“最佳拍档”?

在 AI 应用开发的世界里,Dify 并非唯一的玩家。让我们把它放到一个“竞技场”里,与一些主要的竞争对手或相关平台进行一场公平的比较,看看谁更能满足你的需求。

| 特性维度 | Dify | LangChain | n8n | FastGPT | MaxKB |

|---|---|---|---|---|---|

| 目标用户 | 产品经理、市场营销人员、业务分析师、希望快速构建和部署生成式 AI 应用的团队、寻求快速原型设计和部署的开发者、希望集成 AI 驱动自动化而无需大量编码的企业。 | 熟练 Python 编程的开发者、需要高度定制化 AI 解决方案的技术团队、高级 AI 项目。 | 自动化工程师、开发者、集成专家、寻求开源自动化解决方案的企业、需要定制化工作流自动化的技术用户。 | 寻求基本 AI 功能且追求快速部署和低成本的场景、教育问答、电商客服等轻量级对话应用。 | 旨在企业级的开源 AI 助手用户。 |

| 核心功能 | 开源 LLM 应用开发与运营平台;可视化编排工作室;Prompt IDE;内置 RAG 引擎(支持多种文件格式、混合搜索、重排序、多路径检索);Agent 框架(50+内置工具,支持 Function Calling 和 ReAct);LLMOps(监控、日志、标注、内容审查);Backend as a Service (BaaS) API;支持聊天助手、Agent、工作流等多种应用类型;多模态 LLM 输出;支持私有化部署。 | 用于构建 LLM 应用的开源 Python 库;模块化可扩展框架,连接 LLM 与数据、计算;核心组件包括链(Chains)、Agent、工具(Tools)、记忆(Memory)、检索器(Retrievers);RAG 实现;支持带记忆的对话式 AI;LLM 驱动的数据管道;LangServe 用于部署 RESTful API;LangSmith 用于监控和优化。 | 开源工作流自动化工具;可视化节点式界面;广泛的集成(400+预构建连接器);支持自定义代码(JavaScript);工作流自动化(触发器、计划任务、复杂业务流程);通过第三方 AI 服务(OpenAI、Hugging Face、LangChain 节点)灵活嵌入 AI 功能;可自托管。 | 基于 LLM 的开源 AI 知识库平台;数据处理、模型调用、RAG 检索的开箱即用能力;可视化 AI 工作流编排;支持 DeepSeek 和 OpenAI 模型;可视化工作流设计;支持导入多种数据格式(PDF, CSV 等)。 | 即插即用、灵活的 RAG 聊天机器人;无缝集成 RAG 管道;支持强大的工作流;提供 MCP (Model Context Protocol) 工具使用能力;支持 DeepSeek 和 OpenAI 模型。 |

| 易用性 | 对初学者和非程序员非常友好,拥有可视化界面,低代码/无代码开发。简化 AI 应用创建过程。 | 代码中心化,需要 Python/JavaScript/TypeScript 编码能力。学习曲线较陡峭,但提供更高灵活性。对于非技术用户不太友好。 | 拥有可视化界面,但对非开发者有一定学习曲线。比 Dify 需要更多技术专业知识。 | 简单直观,上手快,学习曲线平缓。 | 即插即用,意味着易用性较高。 |

| 灵活性与可扩展性 | 完善的 UI 解决方案;灵活的模型集成(模型中立,支持 OpenAI、Hugging Face、Replicate、LocalAI、Llama2、Claude 2.1);可视化工作流构建器;部分方面可能缺乏细粒度控制;提供 SDK;工作流可作为构建块或工具。 | 高度可定制化和灵活性,通过代码实现。可根据特定需求进行定制并与现有代码库集成。支持各种向量数据库;模块化设计允许自定义组件和 Agent。 | 高度可扩展,支持自定义节点、脚本和 API 集成。为复杂自动化管道提供细粒度控制。 | 模型选择相对有限,功能深度和可扩展性稍显不足。 | 支持强大的工作流和 MCP 工具使用;灵活的 RAG 聊天机器人。 |

| 集成能力 | 与流行 AI 模型无缝集成,支持 Zapier 等外部工具,提供 API 集成。拥有组件和插件市场。 | 与各种 AI 服务(OpenAI、Google AI、Hugging Face、LlamaIndex 等)集成。 | 广泛的系统集成,强大的 API 编排能力。与各种应用程序和服务集成。 | 支持各种模型,但不如 Dify 或 LangChain 广泛。 | 集成 RAG 管道和 MCP 工具。 |

| 社区支持 | 强大的开源社区(290+贡献者),活跃度高,持续更新。拥有专门的研发团队。 | 大型活跃社区,拥有丰富的文档和支持(GitHub 星标数 98,700+)。开源项目依赖社区力量。 | 活跃的开源社区。 | 社区规模较小,更新稳定但创新相对较慢。 | 开源项目,具体社区活跃度未详述。 |

| 开源协议 | Apache 2.0。开源许可证限制性较强,禁止开发竞争性服务。 | MIT 许可证。 | Fair-code 模型(社区版开源)。 | 开源。 | 开源。 |

| 商业化定价策略 | 免费沙盒计划(200 OpenAI 调用),专业版($59/月),团队版($159/月),企业版(联系销售)。提供云服务和自托管选项。 | 免费开发者层(1个开发者席位,调试跟踪,数据集收集),Plus 版($39/用户/月,最多10个席位),企业版(定制价格)。 | 免费(开源社区版),云计划(Starter $24/月,Pro $60/月,企业版联系销售)。 | 主要以云部署为主,自部署选项相对有限。定价细节未明确,但提及“低成本”。 | 搜索结果中未明确提及。 |

总结选择建议:

- Dify: 如果你希望快速构建和部署多样化的 AI 应用,团队中有非技术人员,并需要完善的 UI 和 LLMOps 支持,那么 Dify 是理想的“开箱即用”选择。

- LangChain: 如果你的团队具备强大的编程能力(尤其是 Python),并需要对 LLM 应用的行为进行高度定制化和精细控制,那么 LangChain 将提供最大的灵活性和代码控制力。

- n8n: 如果你的核心需求是自动化复杂的业务流程,并将 AI 能力作为其中一环进行集成,那么 n8n 将是更合适的工具,因为它专注于强大的工作流自动化和广泛的系统集成。

- FastGPT: 对于追求快速上线和低成本的轻量级知识库问答应用,FastGPT 能够提供简洁有效的解决方案。

- MaxKB: 如果你需要预构建的 RAG 聊天机器人和企业级 AI 助手,并注重工作流能力的团队,可以考虑 MaxKB。

有趣的是,Dify 和 n8n 甚至可以协同作战:Dify 负责构建核心 AI 逻辑,而 n8n 处理复杂的系统集成和自动化,从而创造出更强大的混合 AI 自动化解决方案。

Dify 环境配置指南:搭建你的AI“实验室”

无论你是想快速体验 Dify 的魅力,还是想在自己的“地盘”上完全掌控它,Dify 都提供了灵活的部署选项。

Dify Cloud 服务:即刻体验,无需烦恼

Dify Cloud 是官方提供的托管服务,就像一个“拎包入住”的 AI 实验室。它省去了你配置环境的繁琐,让你能够立即投入到 AI 应用的构建中。

- 注册流程: 访问 Dify 官方网站,轻松注册,选择你的套餐,即可开始创作。

- 套餐权益对比: Dify Cloud 提供了多种套餐,满足从个人学习者到大型企业的不同需求。

- 免费沙盒计划 (Free Sandbox): 适合尝鲜和小型测试,就像一个免费的“试玩区”,通常有调用次数限制(如每月 200 次 OpenAI 调用)。

- 专业版 (Professional): 个人开发者或小型团队的“专属实验室”,提供更多功能和资源(例如 $59/月)。

- 团队版 (Team): 中型团队的“协作空间”,资源更丰富,协作功能更强(例如 $159/月)。

- 企业版 (Enterprise): 为大型企业量身定制的“豪华实验室”,提供最全面的功能、高级安全特性和定制化服务,需联系销售。

Dify 本地化部署 (Docker Compose):完全掌控,打造你的专属AI“堡垒”

如果你想拥有对 Dify 环境的完全控制,或者出于数据安全考虑需要私有部署,Docker Compose 是你的最佳选择。它能让你在自己的服务器上搭建一个完整的 Dify 运行环境,就像为你的 AI 应用建立一个“私人定制工厂”。

前置依赖

在“施工”之前,请确保你的系统安装了以下“工具”:

- Git: 用于从 GitHub 克隆 Dify 的“蓝图”代码。

- Docker 和 Docker Compose: Dify 的“动力核心”,它将 Dify 的所有组件打包成一个个独立的“集装箱”,确保它们在任何环境下都能和谐运行。

详细安装步骤

- 克隆 Dify 仓库: 打开你的终端,输入这行神秘咒语,将 Dify 的代码“召唤”到你的本地:

git clone https://github.com/langgenius/dify.git - 进入 Dify 目录: 就像进入“施工现场”一样,切换到 Dify 的代码目录:

cd dify - 创建

.env配置文件: Dify 的“配置秘籍”藏在.env文件里。先复制一份示例:cp .env.example .env - 配置

.env文件 (重要): 用文本编辑器打开.env文件,这里面有你需要填写的“参数”,比如:SECRET_KEY: 就像你的“超级密码”,一定要随机且强大!SQLALCHEMY_DATABASE_URI: 数据库连接信息。OPENAI_API_KEY或其他 LLM 模型的 API 密钥:这是你 AI 应用的“能量源”,别忘了配置。EDITION: 本地部署请设为SELF_HOSTED。WEB_PORT,API_PORT: 前端和后端服务的“门户”端口。- 其他:根据你的需求调整日志级别、存储类型等。

- 启动 Dify 服务: 一切就绪!输入这行命令,让你的 Dify “工厂”开始运转:

docker compose up -d-d让它在后台默默工作。第一次启动可能需要下载一些“零件”,请耐心等待。 - 访问 Dify Web 界面: “工厂”启动后,在浏览器中打开

http://localhost:80(如果端口没改的话),你将看到 Dify 的“大门”,首次访问需要注册管理员账户。

更新和维护命令

- 更新 Dify: 停止旧版本,拉取新代码,重新构建并启动。

cd dify docker compose down # 停止并删除容器 git pull # 拉取最新代码 docker compose up -d --build # 重新构建并启动服务 - 停止 Dify 服务:

docker compose stop - 停止并删除容器 (保留数据):

docker compose down - 停止并删除容器和数据 (谨慎使用):

docker compose down -v - 查看 Dify 服务状态:

docker compose ps - 查看服务日志:

docker compose logs -f

常见安装问题的解决方案

就像任何“建筑项目”一样,部署过程中可能会遇到一些“小麻烦”,但别担心,这些问题都有解决方案:

- 端口冲突: 就像两辆车抢一个停车位,某个端口被占用了。你可以检查占用端口的程序,或者修改

.env文件中的WEB_PORT和API_PORT。 docker compose command not found: 检查 Docker Compose 是否安装正确,或者是不是打错了命令(docker composevsdocker-compose)。- 数据库连接问题: 就像“工厂”里的部门无法与“档案室”连接。检查数据库容器是否启动,

.env文件中的数据库配置是否正确,防火墙是否阻止了连接。 git clone失败或网络问题: 就像“采购清单”无法送到“供应商”手里。检查网络连接,或者尝试使用代理。- 内存或 CPU 不足: Dify 和 LLM 需要足够的“动力”。检查你的机器资源,或者调整 Docker 分配的内存和 CPU。

- 文件权限问题: 就像“工人”没有权限进入某个“仓库”。确保 Dify 目录有正确的读写权限。

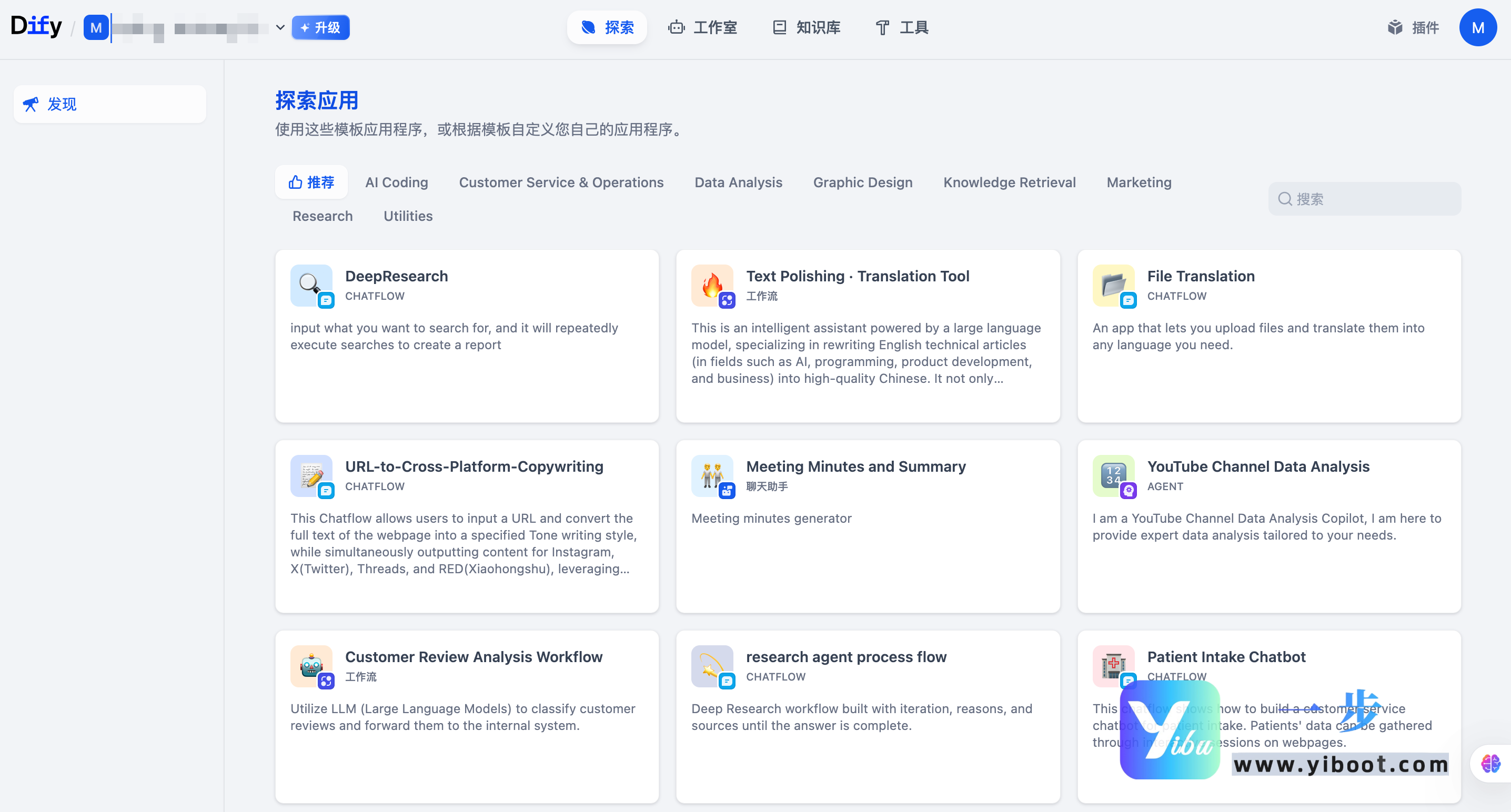

Dify 界面导览:探索你的AI“控制面板”

Dify 的界面设计非常用心,它把复杂的功能“隐藏”在直观的图形界面下,让你能轻松驾驭。这就像一个为 AI 创作者量身定制的“控制面板”。

-

Dify 主仪表盘 (Dashboard) —— 你的“AI 应用指挥中心”

当你首次登录 Dify,映入眼帘的就是这个简洁而强大的仪表盘。它就像你 AI 帝国的“总览图”,你所有的 AI 应用都井然有序地排列在此。

- 应用列表: 清晰展示了你所有的 AI 助手、Agent 和工作流,一目了然。

- 快速创建: 那个醒目的“创建应用”按钮,就像一个通往无限创意的传送门。

- 导航栏: 左侧的导航栏是你通往不同功能区域的“快速通道”,比如“数据集”(知识库)、“工具”和“模型提供商”。

-

应用创建流程 —— 梦想照进现实的第一步

开始一个 AI 项目就像画一幅画,第一步是选择你的“画笔”类型。

- 选择应用类型: 你可以选择构建一个简单的聊天助手、一个能自主思考的 Agent 智能体,或者一个复杂而自动化的工作流。每种类型都对应着不同的 AI 魔法。

- 填写基本信息: 给你的应用起个响亮的名字,写下它的“使命宣言”。

- 进入配置界面: 恭喜你,你的 AI 应用雏形已现!接下来就是给它注入“灵魂”和“能力”了。

-

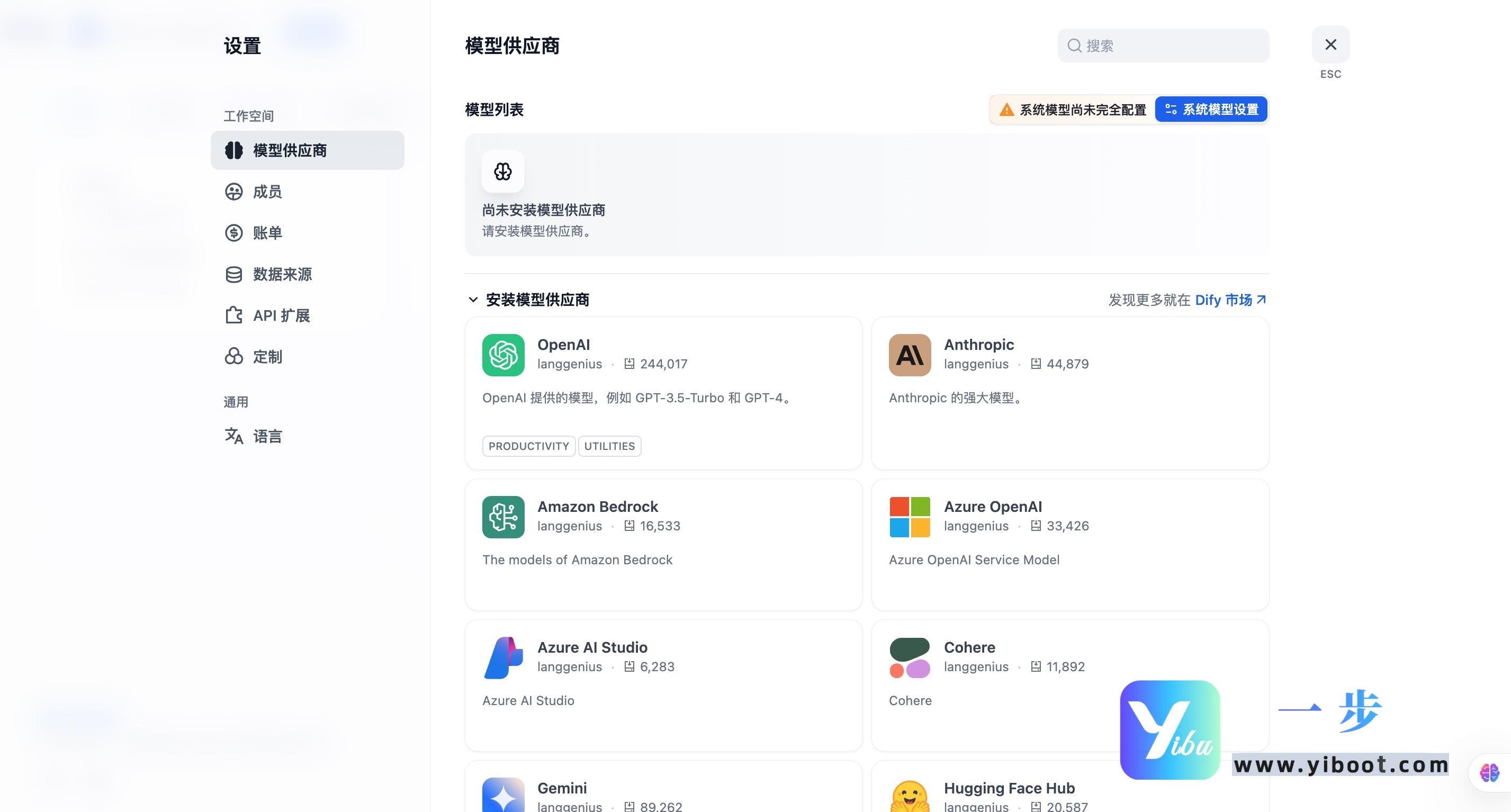

模型供应商的配置与管理 —— AI 的“大脑连接器”

Dify 的强大之处在于它的“模型中立”策略,你可以自由选择各种大语言模型。但首先,你需要告诉 Dify 如何连接它们。

- 导航到“模型提供商”: 在左侧导航栏找到“模型提供商”,这里是所有 AI 模型的“入口”。

- 添加/管理模型: Dify 列出了它支持的所有主流模型提供商,如 OpenAI、Anthropic 等。

- 配置 API Key: 就像给你的 AI 模型通上“电源”,输入相应的 API Key,保存后,这些强大的“大脑”就可以为你的应用服务了。

-

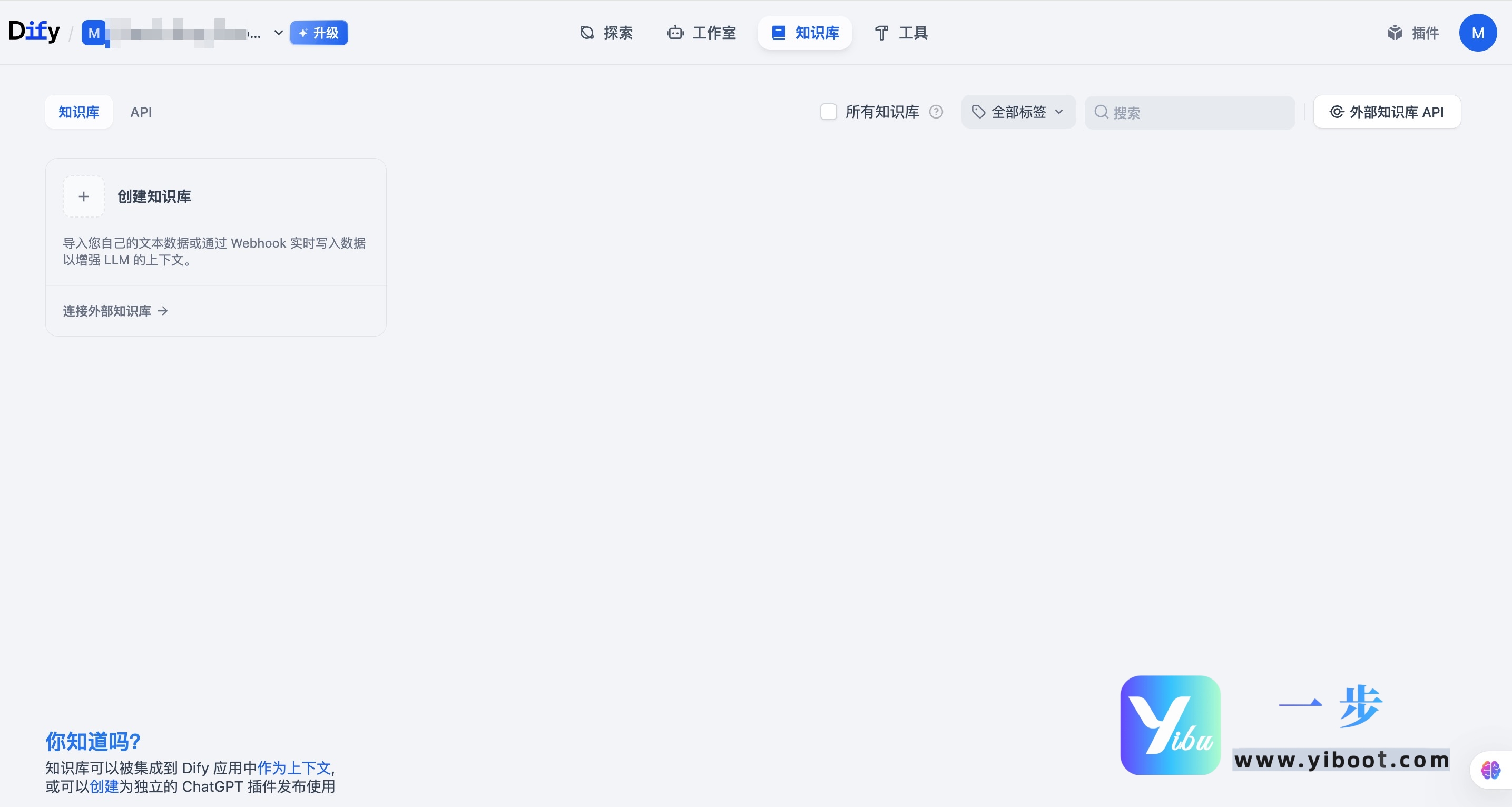

知识库的创建与文档上传 (数据集) —— 赋予 AI “百科全书”

为了让你的 AI 不再“凭空想象”,而是能基于真实知识回答问题,你需要给它一个“知识库”。

- 导航到“数据集”: 在左侧导航栏点击“数据集”,这里是你所有知识的“藏宝阁”。

- 创建数据集: 建立一个新的知识库,给它一个清晰的名字。

- 上传文档: Dify 就像一个“超级图书管理员”,支持多种文档格式(TXT, PDF, DOC, CSV 等)。你只需简单拖拽,它就会自动进行文本提取、分块和向量化,让你的文档变成 AI 可读的知识。

-

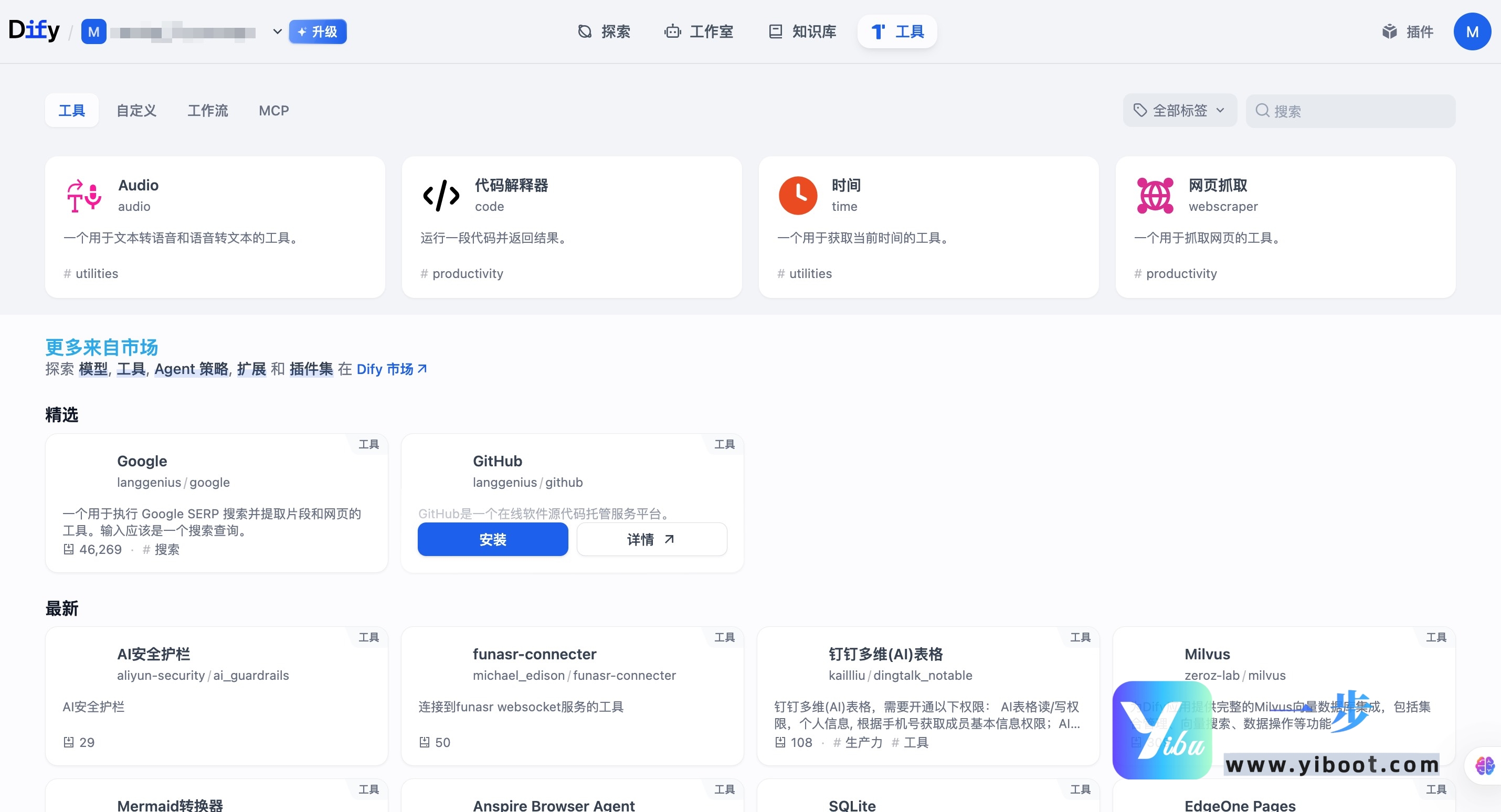

工具的使用 —— 让 AI 拥有“十八般武艺”

Agent 智能体之所以强大,是因为它能够调用外部工具,就像人类会使用手机、电脑一样。

- 导航到“工具”: 左侧导航栏的“工具”区域是 AI 技能的“训练场”。

- 添加工具: Dify 内置了丰富的工具,你也可以通过 OpenAPI 规范或自定义代码添加新的“技能”。

- 配置工具: 为工具设置必要的参数,比如 API 密钥。

- 在应用中启用工具: 在你的 Agent 应用配置中,选择并启用这些工具,你的 AI 智能体就拥有了执行特定任务的“手脚”。

-

日志查看与数据标注 —— 优化 AI 的“反馈回路”

一个优秀的 AI 应用,离不开持续的优化。Dify 提供了关键的 LLMOps 功能,让你能够了解 AI 的运行状况并不断改进。

- 导航到应用概览: 进入你的某个 AI 应用的详情页。

- 查看日志: 这里记录了 AI 每次调用的“成长日记”,包括输入、输出和耗时,帮你洞察其运行轨迹。

- 数据标注: 这就像给 AI “批改作业”。你可以对模型输出的错误进行纠正,或者提供更好的回答示例。这些“批改”过的数据,是未来模型微调和性能提升的宝贵财富,让你的 AI 越学越聪明!

调研说明

更大的图景:Dify如何融入AI生态?

Dify 的出现,不仅仅是又一个开发工具,它是对 AI 民主化浪潮的有力推动者。它让曾经只有少数专家才能触及的 LLM 技术,变得人人可及。通过融合 LLMOps、BaaS 和 Agentic AI 的前沿理念,Dify 不仅降低了技术门槛,更构建了一个完整的 AI 应用生命周期管理平台。这就像在浩瀚的 AI 星空中,Dify 为我们建造了一座易于操作的“太空站”,让更多的人能够登上飞船,探索 AI 的无限可能。它预示着 AI 不再是遥不可及的科学幻想,而是触手可及的生产力工具。

实际应用:Dify 的潜力与未来

Dify 的实际应用潜力是巨大的。从智能客服的效率革命,到企业知识管理的智能化升级,再到内容创作的自动化提速,它正在改变我们与 AI 互动的方式。特别是在金融、医疗等对数据安全和效率有严格要求的行业,Dify 的私有化部署能力使其成为企业级 AI 解决方案的理想选择。未来,我们可以期待 Dify 在更多垂直领域生根发芽,孵化出更多颠覆性的 AI 应用,真正将 AI 能力转化为 tangible 的业务价值。

幕后故事:设计哲学与挑战

Dify 成功的背后,是其独特的设计哲学——化繁为简。其模块化的技术架构,从 API 服务到 Worker、从前端界面到 SDK,每个组件都经过精心设计,以确保平台的灵活性、可扩展性和高可用性。这不仅体现了卓越的工程能力,也反映了对用户需求的深刻理解。当然,在快速迭代的 AI 领域,保持技术领先、兼容最新的模型、并解决用户在私有部署中遇到的各种环境问题(例如前面提到的端口冲突、数据库连接等),都是 Dify 团队需要持续面对和克服的挑战。

下一步:AI 的无限可能

Dify 的发展是动态且充满活力的。随着大模型技术的不断演进,我们可以预见 Dify 将持续集成更多先进的模型,拓展更丰富的工具和插件生态,让 AI Agent 变得更加智能和自主。其 LLMOps 能力也将进一步深化,提供更细致的监控、更智能的优化建议。Dify 正在构建的,不仅仅是软件,而是一个生生不息的 AI 创新生态系统,它将持续激发我们对 AI 边界的探索,带领我们进入一个更智能、更高效的未来。